January

31st,

2017

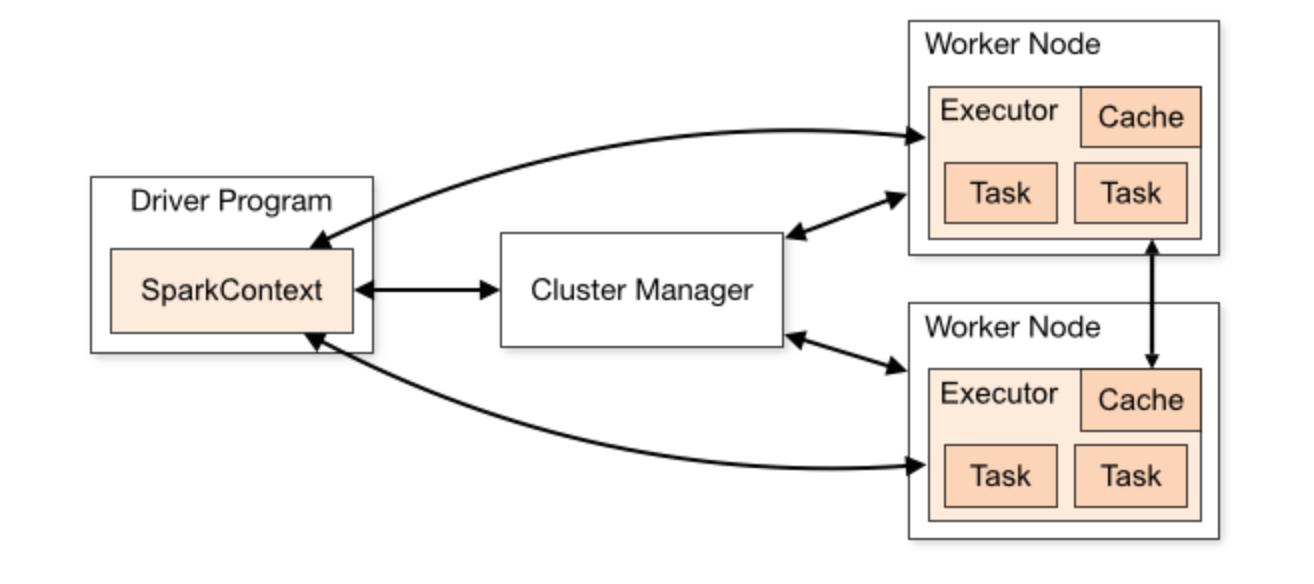

스파크 스탠드얼론 클러스터 요소

스파크 홈페이지에서 상세 정보들을 제공한다.

Spark Cluster 참조링크

스파크 홈페이지에서 상세 정보들을 제공한다.

Spark Cluster 참조링크

스탠드얼론 클러스터 실행

1. $SPARK_HOME/bin/spark-submit를 사용하여 배포파일(.jar)을 빌드하는 방법

2. master/slave shell을 사용하여 빌드를 하고나서 spark-shell로 접속하는 방법

첫번째 방법은 작성한 코드를 한번에 돌릴수 있는 장점이 있다.

두번째 방법은 작성하고자 하는 코드를 바로 입력하여 확인할 수 있다.

이번 글에서는 두번째에 해당하는 방법으로 스탠드얼론 클러스터를 사용할 것입니다.

스파크 스탠드얼론 클러스터 설정 정보

http://spark.apache.org/docs/latest/spark-standalone.html

스파크 설정 파일 복사

1. 디렉토리: $SPARK_HOME/conf

2. spark-env.sh 파일복사: cp spark-env.sh.template spark-env.sh

3. spark-defaults.conf 파일복사: cp spark-defaults.conf.template spark-defaults.conf

spark-defaults.conf 설정 변경

spark-defaults.conf: 드라이버(마스터) 관련한 설정을 하는 파일이다.

1. 파일 열기: vim spark-defaults.conf

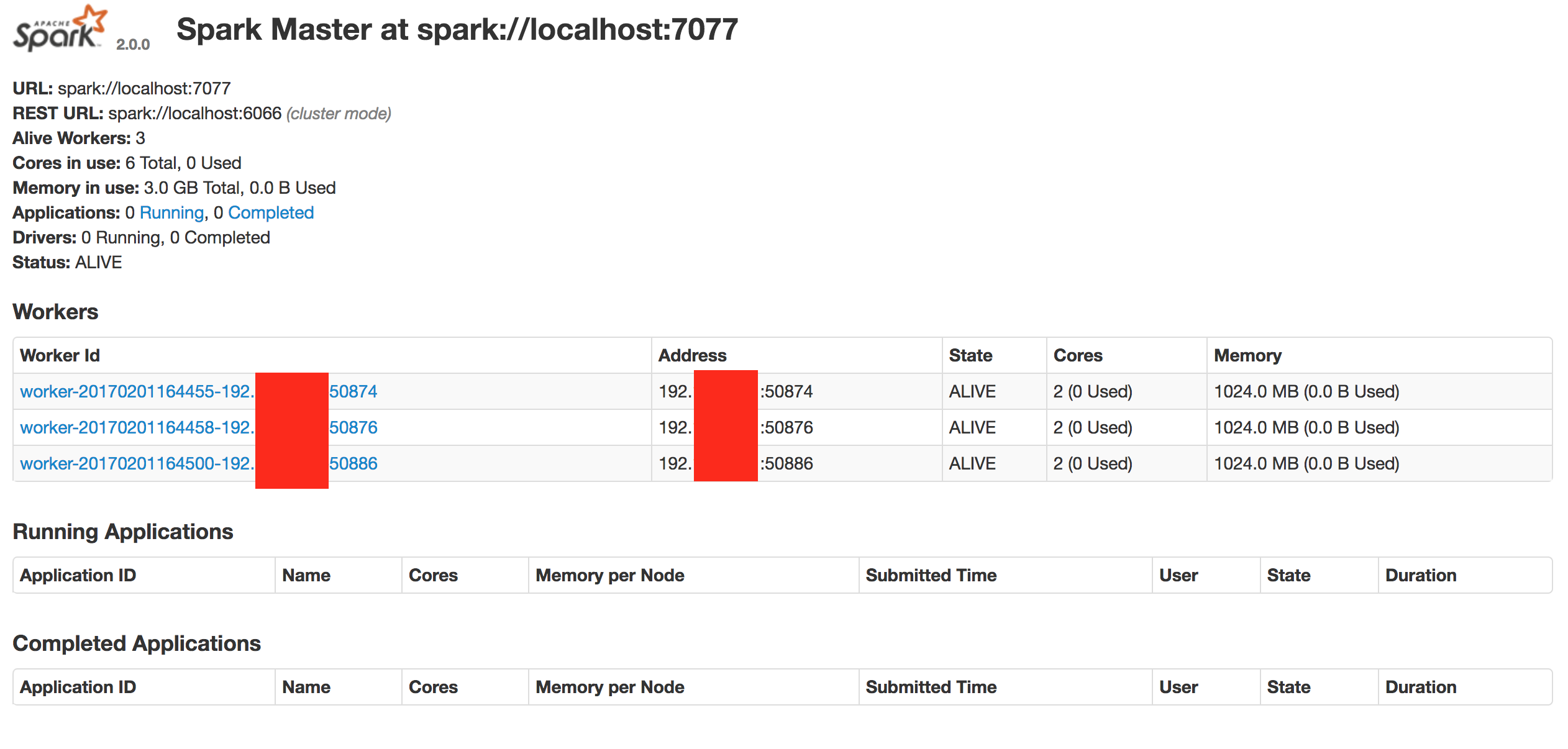

spark-env.sh 설정 변경

spark-env.sh: spark-submit, standAlone, yarn, memos에 관한 각종 설정을 하는 파일이다.

1. 파일열기: vim spark-env.sh

2. export SPARK_MASTER_HOST=호스트네임 (ex. localhost)

3. export SPARK_WORKER_CORES=워커당 코어수 (ex. 2)

4. export SPARK_WORKER_MEMORY=워커당 메모리용량 (ex. 1G)

5. export SPARK_WORKER_INSTANCES=워커 인스턴스 갯수 (ex. 3)

* 2~4번에 해당하는 설정을 실행 시 shell에서 입력할 수도 있다.

- $SPARK_HOME/sbin/start-master.sh -h 호스트네임

- $SPARK_HOME/sbin/start-slave.sh -c 코어수 -m 메모리

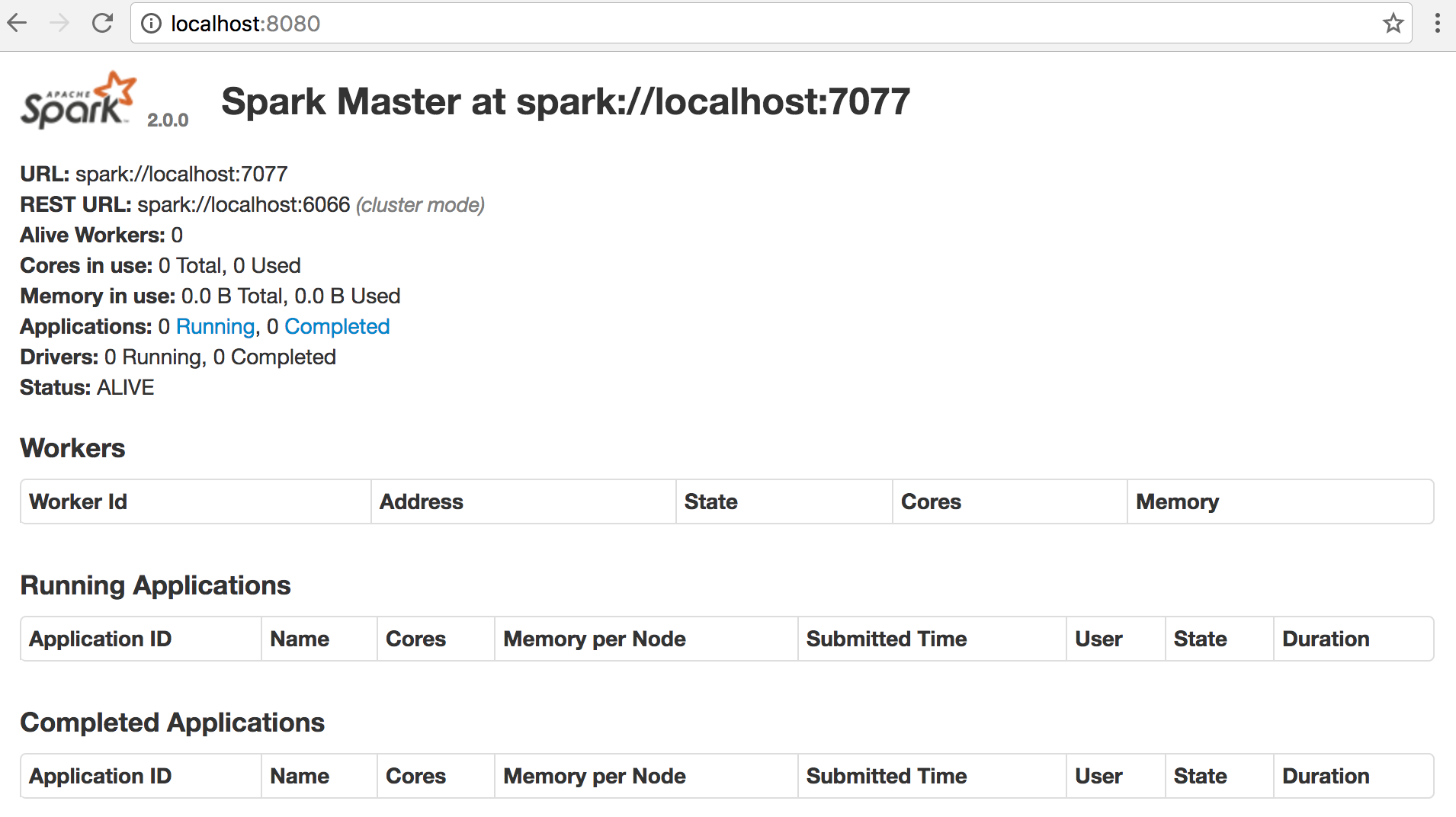

start-master.sh 실행

$SPARK_HOME/sbin/start-master.sh

브라우저에서 웹 접속: http://hostname:port (기본 포트는 80)

start-slave.sh 실행

$SPARK_HOME/sbin/start-slaves.sh spark://localhost:7077

* spark://localhost:7077은 실행중인 master의 URL의 정보이다.

웹UI에서 Workers 확인